# 前言

从25年年初开始,AI Agent有了崛起之势。在使用或者学习Agent的时候,就开始有一个被我忽视的且很重要的概念,那就是“大模型究竟能做些什么?”

#跟踪

如果单独使用大模型提问,或许很容易回答这个问题。我们向大模型提问,大模型通过自身知识库生成我们想要的内容。所以,如果通过Chat类型使用大模型,那么它的作用就是内容生成。

#分析

如果系统地将大模型在整个Chat过程中串联,亦或是将大模型结合MCP、Agent,将其作用进行整体总结,那它可不仅仅是内容生成这么简单。

一,Chat模式下大模型的作用;

1,何为Chat模型:当前最普遍的输入框提问,大模型通过对话形式进行输出的模型,就是Chat模型,例如GPT、DeepSeek、豆包、千问等,C段用户基本都是通过这种输入框提问的模式,称之为Chat模型。

2,Chat模型下大模型能干嘛?

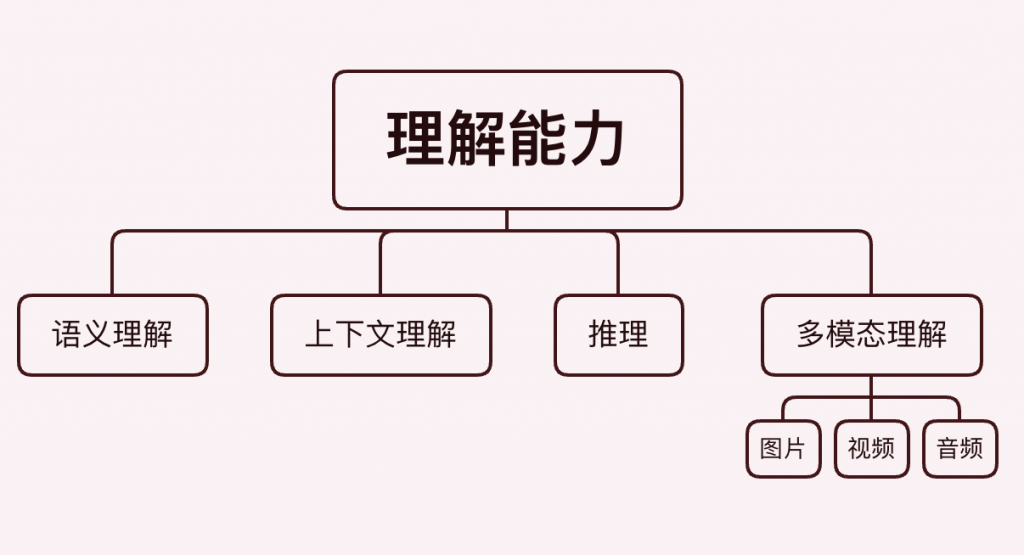

[1],自然语言理解能力,理解用户提出的问题;

# 1,语义理解:

## 示例:

###用户提问:

“古时候的东京是哪个朝代的都城?”

###大模型理解过程:

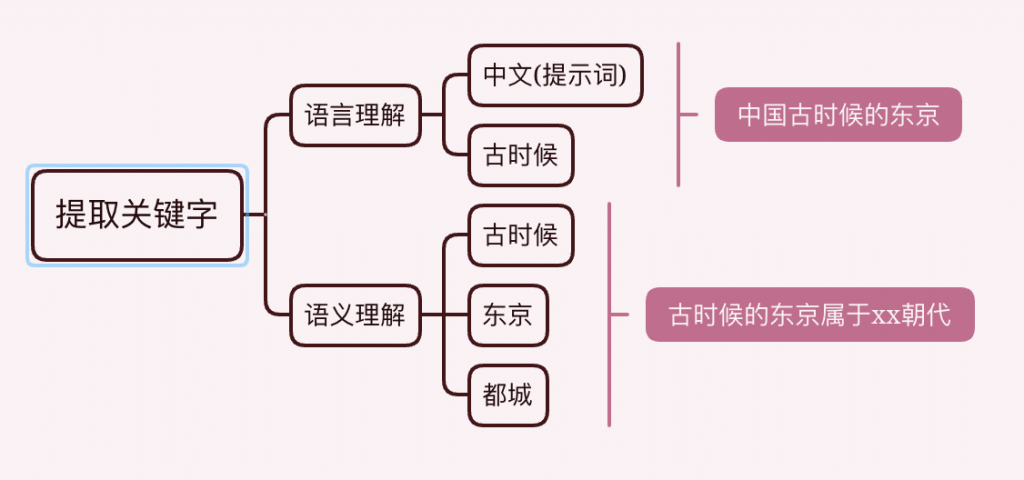

获取提示词 – 提取关键字 – 通过关键字和当前语义环境理解,具体理解过程:

【1】获取提示词之后,看到提示词是中文,大模型就会猜想这里的“东京”,肯定指的是中国古时候的“东京”,而不是日本东京。

【2】根据提示词中的关键字,理解朝代、都城等关键字后,去大模型的知识库匹配结果,最后进行输出;

###大模型输出(简略):

(1),北宋东京;

(2),隋唐东京;

#2,上下文理解

## 示例:

###用户提问:

Chat_Q_1:“我的祖国是中国,它的面积有多大?”

Chat_Q_2:“它的年龄是多大?”

###大模型理解过程:

当模型获取当前对话中以往用户输入的提示词 – 根据会话中所有的提示词进行语义的理解,具体过程为:

【1】,大模型获取第一个问题,“我的祖国是中国,它的面积有多大?”,再回答第一个问题;

【2】,当第二个问题提出后,大模型会记忆第一个问题以及其语义,回答第二个问题的时候,会通过第一个问题的语义去理解“它”具体指的是谁,然后回答“中国的年龄有多大?”这个具体问题;

这就是大模型根据用户上下文去理解语义。

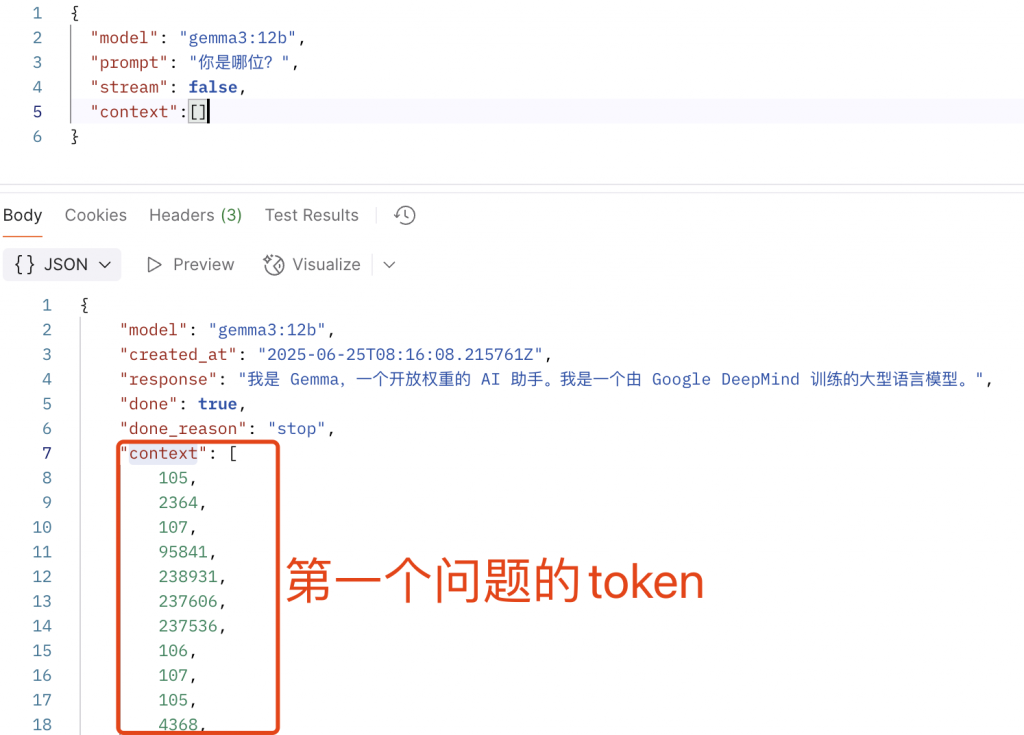

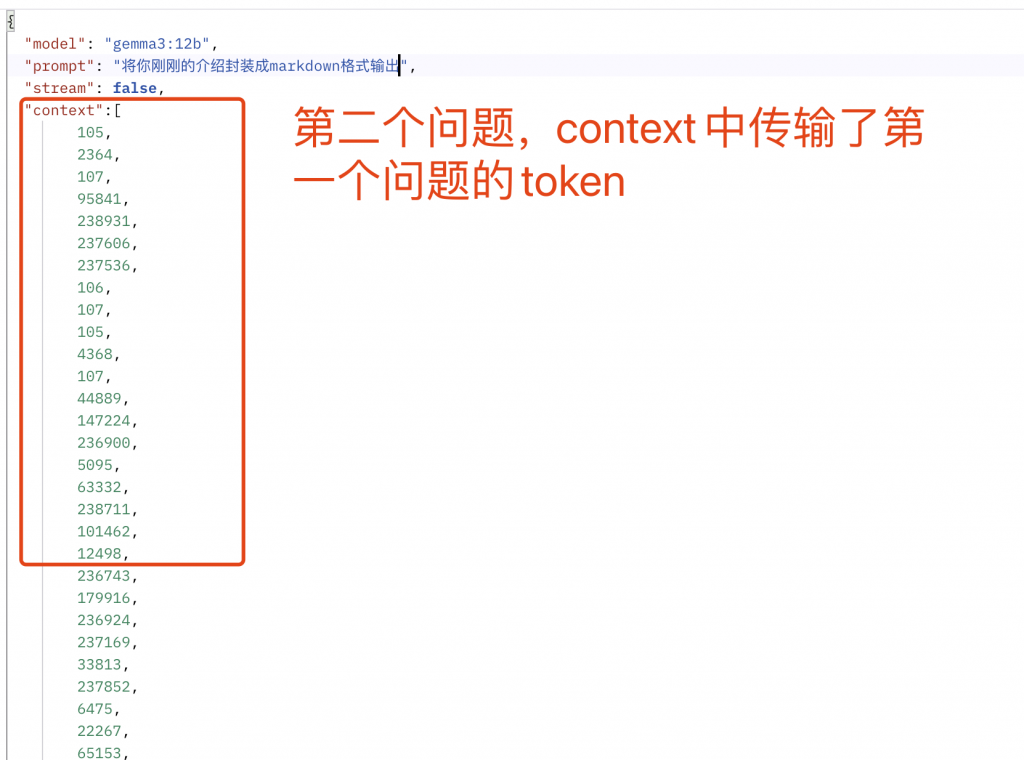

其实在大模型内部,当用户第二次提问的时候,在传参的时,将第一个问题的token以context的形式传递给了大模型,这样它才有了记忆能力,如下:

#3,推理能力,大模型可以通过自身的推理能力,去理解用户提示词中的一些语义

## 示例1:

###用户提问:

“假设X + 2等于10,那么X等于多少?”

###大模型推理过程:

【1】,获取关键点:方程是:X + 2 = 10;

【2】,计算X:X = 10 – 2,X = 8;

【3】,检查等式两边是否相等:8 + 2 = 10;

###推理解释

首先大模型获取到问题(提示词)之后,会进行一些关于数学、物理、逻辑学等一些科学的推理,从而得到结果。这不是最重要的,最重要的是,当推理完成得到结果之后,它会进行反向验证,验证自身的推理是否正确。以上就通过8 + 2 = 10进行了验证。

## 示例2:

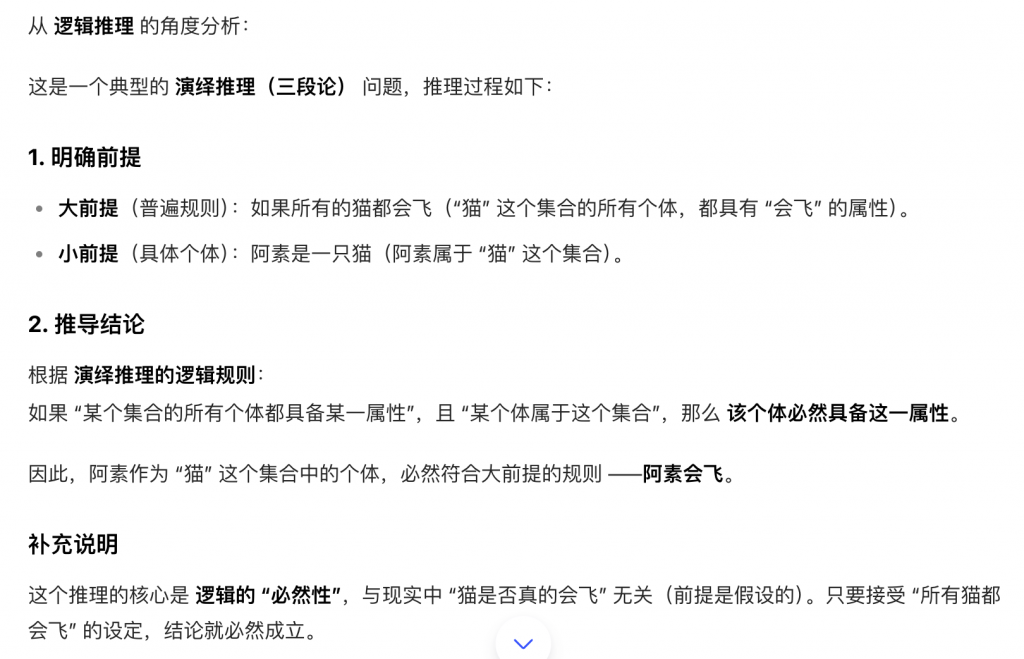

###用户提问:“如果所有的猫都会飞,阿素也是一只猫,那么阿素会不会飞?”

###大模型推理

如图所示:

#4 多模态理解

## 音频理解

whisper转录文字,然后理解其文字;

## 图片、视频理解

多模态理解能力

## 3D等物理空间理解